本地部署 Qwen2.5 7B:Windows 11 + Ollama 的完整指南

随着大语言模型本地部署技术的普及,Ollama 为 Windows 用户提供了简洁高效的本地大模型管理方式。本文以 Qwen2.5 7B 指令微调量化模型为例,详细讲解在 Windows 11 系统下的完整部署流程,包括环境准备、模型量化、显存计算及性能优化。

一、环境准备

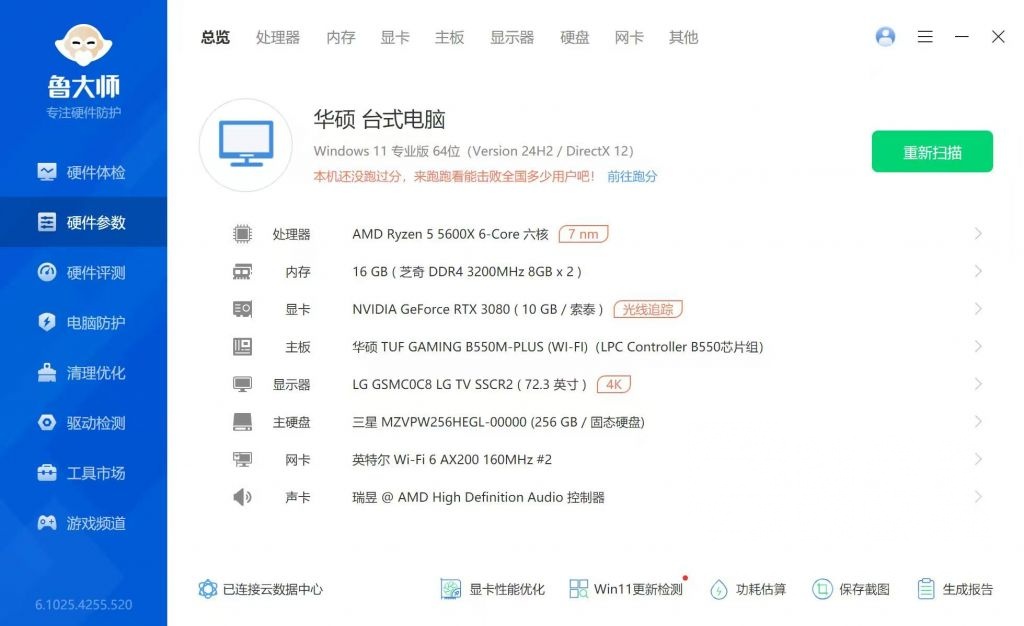

推荐配置如下:

- 操作系统:Windows 11 64位

- CPU:多核、多线程优先(如 12th Gen Intel® Core™ i7-12700H)

- GPU:RTX 3070Ti 8G 或更高(如 RTX 5060 8G)

- 内存:≥16GB RAM

- 硬盘:≥50GB 可用空间

- Python:3.10 版本

💡 注:显存占用主要由权重、激活值、缓存和优化器状态组成。

二、安装 Ollama

-

下载安装包并安装

访问 Ollama 官网,下载 Windows 版安装包 -

验证安装

打开 PowerShell 输入:ollama --version若输出

版本号则表示安装成功。

三、拉取量化模型

Ollama支持直接拉取诸多版本的 Qwen2.5 7B模型,推荐指令微调版,如下:

ollama pull qwen2.5:7b-instruct

该此命令会从 Ollama 的模型库中下载 Qwen2.5-7B 模型指令微调版。首次下载需要一定时间,取决于你的网速(模型大小约 4.7 GB)。

注意:模型名称中的

7b代表 70 亿参数。如果显存不足(如小于8GB),推荐用指令微调+量化版qwen2.5:7b-instruct-q4_0,翻译更自然且显存占用低。也可以尝试qwen2.5:3b或qwen2.5:1.5b等更小版本。

四、显存与内存占用计算

显存占用公式如下:

[

\text{显存} \approx \text{权重占用} + \text{激活占用} + \text{缓存占用}

]

其中:

权重占用 = 参数量 × 量化位数 ÷ 8 (7B 参数 × 4 bit ÷ 8 = 3.5 GB)

激活占用:每 token 约占 4 bytes(FP32)或 2 bytes(FP16)

缓存占用:长上下文或批量推理时增加

⚠️ 注意:长文本推理或并发调用需监控峰值内存,避免显存溢出。`

五、部署与调用示例

1. 配置 Ollama

修改 %USERPROFILE%.ollama\config.json:

{

"model_path": "C:\\ollama\\models",

"cache_path": "C:\\ollama\\cache",

"gpu_enabled": true,

"num_threads": 8

}

2. CLI 调用

ollama run qwen2.5:7b-instruct --prompt "写一段中文技术博客示例"

3. Python 调用

from ollama import Ollama

client = Ollama()

response = client.run("qwen2.5:7b-instruct", prompt="生成一段技术博客示例")

print(response)

六、性能优化建议

1.GPU 层数计算

[

\text{GPU层数} = \min\left(\text{GPU显存} \div 0.2, \text{总层数}\right)

]

例如 8GB 显存可支持约 40 层。

2.环境变量优化

setx OLLAMA_NUM_PARALLEL 2 "# CPU 并行数"

setx OLLAMA_KEEP_ALIVE 5 "# 模型驻留时间(分钟)"

3.化选项选择

- q4_0:最小资源占用

- q5_k_m:平衡精度与性能

- f16:最高精度(显存需求高)

七、常见问题解决

- 显存不足:降低量化级别(如切换至 q4_0)或减少上下文长度。

- 内存溢出:调整 Windows 分页文件大小, 或通过 >ollamaserve –verbose 2>&1 | Out-File -FilePath ollama.log 排查日志。

八、总结

通过 Ollama 部署 Qwen2.5 7B-instruct模型,可在 RTX 3070 8G 显卡上流畅运行,显存占用仅约 5GB。本文涵盖了从环境准备到性能优化的全流程,用户可根据实际硬件条件调整量化策略。如需更高精度或长文本支持,可选择 FP16 或 INT8 版本。

注:本文基于 Ollama 0.11 和 Qwen2.5 7B-instruct 指令微调模型,适用于 Windows 11 环境。如需集成至 VS Code 等编辑器,可安装 Continue 插件并配置本地 API 地址(http://localhost:11434)。